O TikTok anunciou recentemente que irá implementar, apenas nos Estados Unidos até então, as “Notas da Comunidade”, um modelo de moderação que utiliza a própria comunidade de usuários para incluir notas em postagens. A iniciativa não é nova; ela segue os passos do X (antigo Twitter), que popularizou o modelo na plataforma em 2022, sob a gestão do bilionário Elon Musk. Logo após as eleições dos Estados Unidos e a posse do então presidente Donald Trump, Zuckerberg anunciou que também utilizaria a ferramenta nas plataformas da Meta, como Instagram, Facebook e Threads.

Antes de qualquer coisa, precisamos entender como funcionam as notas da comunidade:

Basicamente os usuários colocam seus comentários e sugestões em uma postagem que eles avaliam que necessite de uma nota adicional, um contexto ou até mesmo a necessidade de uma checagem dos fatos. Notas postas, há uma espécie de votação dos próprios usuários; quando elas atingem um número satisfatório, ficam públicas na parte inferior da postagem para todos os usuários. Algo importante precisa ser destacado: não há uma checagem da nota por parte da plataforma; o processo é feito 100% pelos usuários, o que pode deixar brechas para manipulação, equívocos etc

Mas, afinal, o que isso significa? Em um cenário digital cada vez mais poluído por desinformação, mais ferramentas de moderação não deveriam significar um avanço?

Bom, na teoria, sim. O problema é que, na prática, não estamos assistindo a um aumento, mas a um esvaziamento sistemático da moderação profissional nessas plataformas. As big techs estão, aos poucos, substituindo a cara e complexa moderação humana — feita por especialistas e verificadores de fatos — por sistemas de inteligência artificial e “comunidades” de voluntários. O pretexto é nobre: garantir a “liberdade de expressão” e “não cometer injustiças”, contém ironias.

Essa narrativa, no entanto, é extremamente conveniente para um objetivo corporativo: reduzir custos e, principalmente, se isentar da responsabilidade editorial sobre o que circula em suas redes. Ao mesmo tempo, essa ideia encontra um forte eco no discurso de setores da extrema-direita, que trabalham com uma noção abstrata de “liberdade”, que inclui excessos sobre os direitos das outras pessoas.

Mesmo a justificativa da Meta para retirar a parceria com checadores, sob a alegação de uma suposta defesa da “liberdade de expressão”, apresenta alguns furos — principalmente quando se trata da moderação de conteúdo de políticos. Sobre isso, Tai Nalon, diretora executiva do Aos Fatos, esclarece que a parceria com agências de checagem — que, para a jornalista, é muito importante — já tinha limitações que protegiam políticos, e que o discurso das plataformas de que essa parceria poderia causar “censura” era, na verdade, falso.

“A regra da parceria — isso sempre foi assim — é que posts de políticos, mesmo que sejam patentemente mentirosos, não são moderáveis pela parceria dos checadores. Essas checagens não são usadas para a moderação de conteúdos.”

Essa transferência de responsabilidade não se limita à implementação de um sistema falho. Ela também se manifesta nas regras que as próprias plataformas impõem às parcerias de checagem, criando exceções convenientes.

Ao transferir essa decisão para uma “comunidade” e criar exceções para políticos, as plataformas não apenas abdicam de sua responsabilidade legal e moral, mas também criam um ambiente onde o discurso de ódio pode ser legitimado por uma suposta “checagem” comunitária que, na verdade, nunca deveria ter acontecido.

Paulo Rená, pesquisador do Instituto de Referência em Internet e Sociedade (IRIS) e integrante do Aqualtune LAB, complementa apontando para a necessidade de garantias processuais que vão além do modelo comunitário:

“Além de somar as notas da comunidade com o fact-checking, o que a gente considera prioritário são os elementos do devido processo. É importante que as pessoas possam saber por que um determinado conteúdo foi sujeito a uma medida de moderação, que haja a possibilidade de recorrer, que existam prazos específicos para uma resposta da empresa, que o design da plataforma seja adequado para esse acesso, e que tudo esteja bem delimitado, para que as pessoas possam recorrer e fazer valer seus direitos. É isso que nós temos chamado de ‘devido processo’.”

A parceria com as agências de checagem é essencial para a moderação, além de ter uma profundidade incomparável à moderação feita apenas pela comunidade. Tai Nalon explica que o processo de verificação profissional é muito mais complexo e responsável:

“As organizações de checagem têm liberdade editorial para checar aquilo que elas quiserem. No caso do Aos Fatos, temos uma metodologia própria de verificação e de eleger o que deve ser verificável. A eleição do que é verificável é uma combinação de escolhas editoriais inerentes ao jornalismo, calculada a partir do interesse público, ou seja, uma informação que tenha apelo a uma comunidade grande de pessoas, o alcance daquela desinformação, o grau deletério dessa desinformação, além de quem está publicando e disseminando determinada desinformação.”

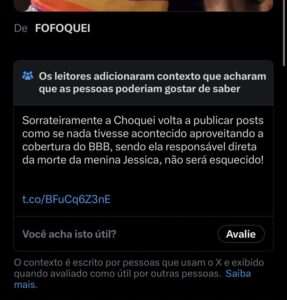

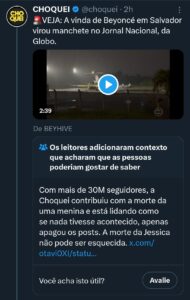

Notas da comunidade podem ser usadas para ataques coordenados

A questão fundamental é se o sistema das notas da comunidade, instaurado no X e na Meta, realmente funciona como prometido. A prática tem mostrado um cenário preocupante. Um exemplo claro de como a ferramenta pode ser desvirtuada vem do próprio X. Durante a crise de imagem da página Choquei, as notas da comunidade foram massivamente utilizadas para atacar o perfil. Sem entrar no mérito das ações da página, o episódio demonstrou que o recurso pode ser facilmente instrumentalizado para campanhas de assédio ou ataques coordenados, desviando-se completamente de seu propósito original de combater a desinformação.

Reafirmando a necessidade de uma abordagem múltipla para combater a desinformação, Nalon afirma:

“Apenas as notas de comunidade não são suficientes para combater a desinformação, assim como apenas a checagem de fatos também não é uma ferramenta suficiente. Na verdade, o que a gente precisa é de uma sobreposição de tecnologias que atuem no combate à desinformação de um modo transparente, mas também efetivo, na medida em que cada tipo de desinformação tem seu impacto negativo na sociedade.”

O colunista do The Washington Post, Geoffrey A. Fowler, avaliou as notas da comunidade da Meta nos últimos meses, e o resultado foi desanimador: das 65 notas que ele criou para sinalizar conteúdos claramente desinformativos, apenas 3 foram aprovadas pela plataforma. Uma taxa de sucesso irrisória que expõe a fragilidade e a falta de efetividade do sistema.

Crimes não são matéria de debate

Além da ineficácia, existe uma questão mais simples. Conteúdos danosos como apologias ao nazismo, abuso infantil, discursos de ódio como xenofobia e racismo, e tantos outros conteúdos criminosos não precisam de uma “nota da comunidade”. Eles não são matéria de debate ou de opinião. São crimes que exigem remoção imediata e a responsabilização de quem os publica — uma tarefa que cabe à plataforma, e não a um voto popular que pode ser manipulado.

Do ponto de vista jurídico, Rená afirma que as notas também podem ter consequências legais para quem as cria:

“Considerando as novas regras afirmadas pelo Supremo Tribunal Federal na interpretação do Artigo 19 [Marco Civil da Internet], à luz da Constituição Federal, as notas da comunidade são, essencialmente, um conteúdo de terceiro em uma rede social. E, até dependendo do conteúdo específico de uma nota aprovada, elas podem responder de forma mais rigorosa.”

Mas o problema vai além. As notas — e agora vamos falar do X (antigo Twitter), pois é onde há mais dados — estão se mostrando falhas. A Lupa demonstrou, em 2023, em uma reportagem exclusiva, que mais de 90% das proposições de notas enviadas em postagens antivacinas ficavam em espera. Ou seja, a nota da postagem com desinformação prejudicial contra a saúde dos usuários nem sequer chegaria aos usuários. O estrago estaria completo.

O movimento liderado por X, e agora seguido por Meta, representa menos um avanço na moderação de conteúdo e mais uma terceirização de responsabilidade. Sob o disfarce de democratizar a verificação, as plataformas digitais estão, na verdade, se distanciando de seu dever de garantir um ambiente seguro, deixando os usuários mais expostos a fraudes, ódio e desinformação, enquanto se protegem por trás da “vontade da comunidade”.

Nos resta esperar e torcer para que o TikTok não siga o caminho das outras plataformas e mantenha a sua moderação com checadores, mesmo que falha em muitos momentos.

Quem assina esta reportagem: Texto e apuração de Licks, jornalista e ativista digital, membro da comunicação do Sleeping Giants Brasil. Arte: Upa.